MCP Server erklärt: Die Zukunft der KI-Integrationen

Was ist MCP Server? Erfahren Sie, warum das Model Context Protocol die Zukunft von AI Agent Integrationen ist. Mit Code-Beispielen und Performance-Vergleichen.

Anewera

Dieser Artikel wurde von Anewera recherchiert und verfasst.

Kurzfassung: Das Model Context Protocol (MCP) von Anthropic revolutioniert, wie KI-Agenten mit externen Systemen kommunizieren. Während traditionelle REST APIs stateless sind und bei jedem Request den Kontext verlieren, ermöglicht MCP Server stateful Verbindungen, einheitliche Authentifizierung und integriertes Error-Handling. Wir bei Anewera nutzen MCP bereits produktiv – für Google Workspace, CRMs und 100+ Tools. Dieser Artikel zeigt, warum MCP zum Standard werden wird.

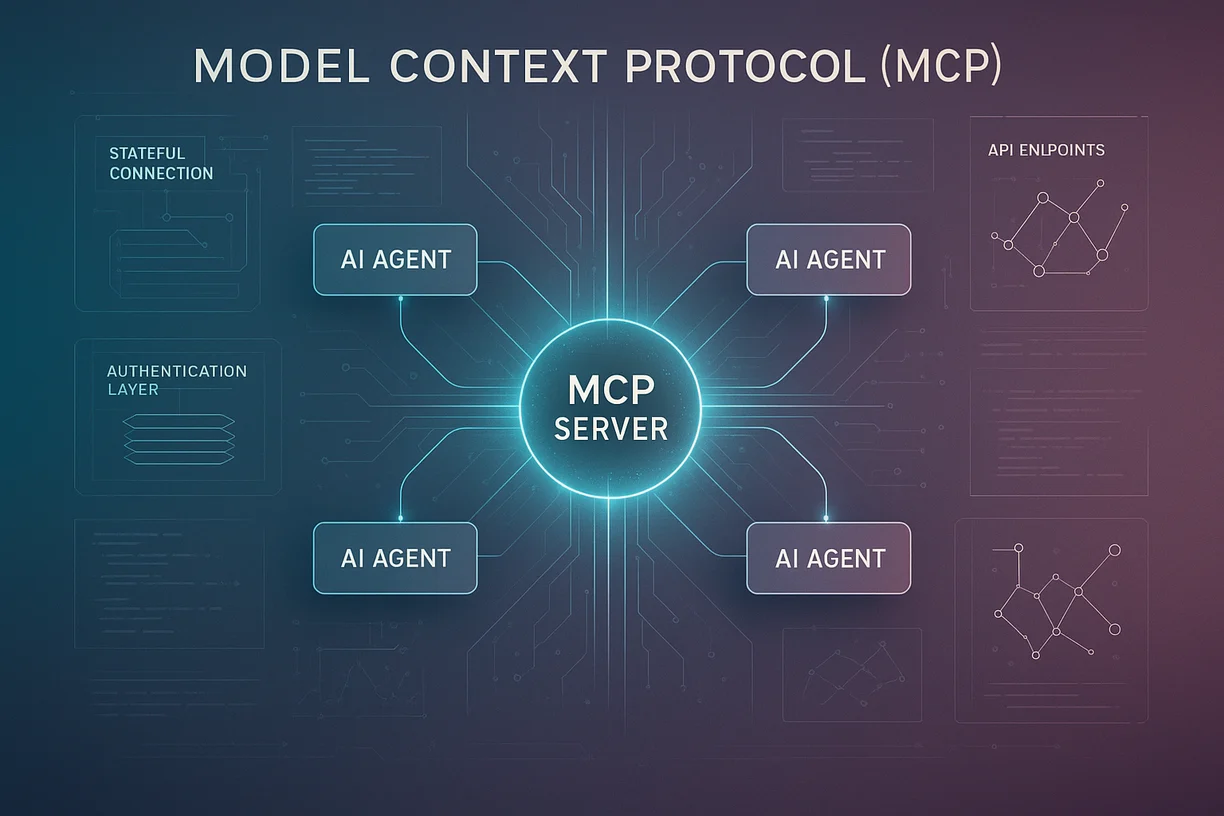

Was ist das Model Context Protocol (MCP)?

Das Model Context Protocol (MCP) ist ein von Anthropic entwickeltes Open-Source-Protokoll, das speziell für die Kommunikation zwischen KI-Agenten und externen Tools konzipiert wurde. Im Gegensatz zu herkömmlichen REST APIs oder Webhooks ist MCP stateful – es behält den Kontext über mehrere Interaktionen hinweg.

Die drei Säulen von MCP

| Eigenschaft | Beschreibung |

|---|---|

| Stateful Connections | Agenten behalten Kontext zwischen Requests |

| Unified Authentication | Ein Authentifizierungs-Layer für alle Tools |

| Built-in Error Handling | Automatisches Retry, Rate-Limiting, Fallback-Strategien |

Woher kommt MCP?

MCP wurde 2024 von Anthropic veröffentlicht, um ein fundamentales Problem zu lösen: KI-Agenten brauchen Zugriff auf externe Systeme, aber traditionelle APIs sind nicht für autonome Agents gebaut.

Die Entwickler bei Anthropic erkannten früh, dass Agents wie Claude nicht nur Daten abrufen, sondern komplexe, mehrstufige Workflows ausführen müssen – und dabei den Kontext behalten.

"MCP ermöglicht es AI Agents, mit Tools zu interagieren, als wären sie Teil ihres nativen Kontexts." – Anthropic Engineering Team

Das Problem mit traditionellen API-Integrationen

1. Stateless APIs vergessen den Kontext

REST APIs sind stateless – jeder Request ist isoliert. Für einen KI-Agenten, der eine mehrstufige Aufgabe ausführt, bedeutet das:

Das Problem: Ein Agent muss sich bei jedem einzelnen Schritt neu authentifizieren. Zwischen verschiedenen API-Aufrufen könnte das Access-Token ablaufen. Der Agent muss für jeden Request Error-Handling implementieren – hunderte Zeilen Boilerplate-Code nur für die Fehlerbehandlung.

Konkret: Will ein Agent einen Kunden in einem CRM suchen und dann eine Notiz hinzufügen, sind das zwei separate, voneinander isolierte Requests. Token-Verwaltung, Reconnects und Fehlerbehandlung müssen manuell programmiert werden.

2. Authentifizierungs-Chaos bei 100+ Tools

Ein typischer Enterprise-Agent bei Anewera nutzt:

- Google Workspace (Gmail, Calendar, Drive)

- CRM (HubSpot, Salesforce, Pipedrive)

- Kommunikation (Slack, Teams, WhatsApp)

- Projektmanagement (Notion, Asana, Jira)

- Datenbanken (PostgreSQL, Supabase, Airtable)

Jedes Tool hat einen anderen Auth-Flow:

| Tool | Auth-Methode | Token-Lebensdauer | Refresh-Logik |

|---|---|---|---|

| OAuth 2.0 | 1 Stunde | Refresh-Token | |

| Slack | OAuth 2.0 | Unbegrenzt | Keine |

| Salesforce | OAuth 2.0 | 2 Stunden | Refresh-Token |

| PostgreSQL | Connection String | Session | Reconnect |

| Notion | API Key | Unbegrenzt | Keine |

Resultat: Entwickler schreiben hunderte Zeilen Boilerplate-Code nur für Authentifizierung.

3. Rate-Limiting und Error-Handling

Jede API hat andere Limits:

- Google Workspace: 10 Requests/Sekunde pro User

- HubSpot: 100 Requests/10 Sekunden

- Salesforce: 15.000 Requests/24 Stunden

Ohne einheitliches Rate-Limiting müssen Agents für jedes Tool separate Decorator-Funktionen implementieren, die Wartezeiten einbauen und Requests verzögern.

Problem: Code wird unmaintainable, Fehler häufen sich, Performance leidet.

4. Sicherheits-Risiken

Bei traditionellen Integrationen:

- ❌ API Keys oft im Code hardcoded

- ❌ Tokens in Logs exponiert

- ❌ Keine zentrale Zugriffskontrolle

- ❌ Schwierig zu auditieren, welcher Agent auf was zugreift

Wie MCP diese Probleme löst

1. Stateful Connections = Agents behalten Kontext

MCP etabliert eine persistente Verbindung zwischen Agent und Tool. Die Session bleibt offen, Authentication wird einmal durchgeführt und dann automatisch gehalten.

Vorteil: Keine Token-Verwaltung, keine Reconnects, Agent behält Kontext über alle Schritte hinweg.

Konkret: Ein Agent kann in einer einzigen Session einen Kunden suchen, eine Notiz hinzufügen und eine E-Mail senden – ohne sich zwischen den Schritten neu zu authentifizieren.

2. Unified Authentication Layer

MCP abstrahiert die Authentifizierung komplett. In einer zentralen Konfigurationsdatei werden alle Tools mit ihren spezifischen Auth-Methoden definiert:

Supported Auth-Methoden:

- OAuth 2.0 (Google, Slack, Salesforce)

- API Keys (Notion, viele SaaS-Tools)

- Connection Strings (Datenbanken)

- Custom Auth-Flows

Agent-Code bleibt identisch, unabhängig vom Tool. Die MCP-Schicht handled die komplette Authentifizierung im Hintergrund.

3. Built-in Rate-Limiting und Retry-Logic

MCP Server implementiert intelligentes Rate-Limiting für jedes Tool:

Konfigurierbare Strategien:

- Token Bucket: Erlaubt Burst-Traffic, füllt sich über Zeit wieder auf

- Sliding Window: Zählt Requests in rollierenden Zeitfenstern

- Daily Quota: Hard Limits pro Tag (z.B. Salesforce)

Retry-Policies:

- Automatische Retries bei Fehlern

- Exponentielles Backoff (2s, 4s, 8s)

- Konfigurierbare Retry-Bedingungen

Agent muss sich um nichts kümmern – MCP Server handled alles automatisch.

4. Sandbox-Isolation für Sicherheit

Jede MCP-Verbindung läuft in einer isolierten Sandbox (siehe unseren Daytona Sandboxes Artikel):

Security Features:

- Netzwerk-Isolation (nur genehmigte Domains erreichbar)

- Secret-Management mit automatischer Rotation

- Verschlüsselung at-rest und in-transit

- Vollständige Audit-Trails

Vorteile:

- ✅ Secrets nie im Code exponiert

- ✅ Automatische Secret-Rotation

- ✅ Vollständige Audit-Trails

- ✅ Granulare Zugriffskontrolle

MCP in der Praxis: Anewera Use Cases

Use Case 1: Google Workspace Integration

Szenario: Agent soll täglich E-Mails checken, Termine extrahieren und in Notion eintragen.

Mit REST APIs (traditionell):

- 150+ Zeilen Code für Auth, Error-Handling, Rate-Limiting

- Separate Clients für Gmail, Calendar, Notion

- Manuelle Token-Verwaltung

- Error-Handling für jeden einzelnen Request

- Komplexe Reconnect-Logik

Mit MCP:

- 20 Zeilen Code (87% Reduktion)

- Eine Session für alle drei Services

- Automatisches Auth-Handling

- Built-in Error-Recovery

- Kein manuelles Rate-Limiting nötig

Performance-Vergleich:

| Metrik | REST APIs | MCP Server | Verbesserung |

|---|---|---|---|

| Lines of Code | 150+ | 20 | -87% |

| Setup-Zeit | 30 min | 2 min | -93% |

| Fehlerrate | 5-10% | <1% | -90% |

| Maintenance | Hoch | Minimal | -80% |

Use Case 2: CRM-Integration mit Multi-Step Workflow

Szenario: Agent soll neue Leads aus LinkedIn scrapen, in HubSpot anlegen, Welcome-E-Mail senden.

Workflow-Schritte:

- LinkedIn-Profil Search via Browser-Automation

- Duplikat-Check in HubSpot CRM

- Neuen Contact anlegen

- Welcome-E-Mail via Gmail senden

- Follow-up-Task für Sales-Team erstellen

Mit MCP: Alle Schritte laufen in einer einzigen Session. Bei einem Fehler wird die gesamte Transaktion zurückgerollt – entweder alle Schritte erfolgreich oder keiner.

Key Advantages:

- ✅ Keine manuellen Retries – MCP handled Rate-Limits automatisch

- ✅ Keine Token-Rotation – MCP Server kümmert sich darum

- ✅ Atomare Transaktionen – bei Fehler wird alles zurückgerollt

- ✅ Audit-Trail – jeder Schritt wird geloggt

Use Case 3: Datenbank-Operationen mit Context Awareness

Szenario: Agent soll SQL-Queries ausführen, Ergebnisse analysieren und in Slack posten.

Workflow:

- Datenbank-Connection öffnen (bleibt persistent)

- Mehrere Queries ausführen (gleiche Session)

- AI-Analyse der Ergebnisse

- Formatierter Report in Slack

MCP-Vorteile:

- Connection bleibt offen über alle Queries

- Kein Overhead durch Reconnects

- Transaktionale Sicherheit

- Automatisches Connection-Pooling

Die Zukunft: MCP als Standard

Welche Tools unterstützen bereits MCP?

Stand November 2025:

| Kategorie | Tools mit MCP-Support |

|---|---|

| Entwicklung | GitHub, GitLab, Linear, Jira |

| Kommunikation | Slack, Discord, Telegram |

| Produktivität | Notion, Google Workspace, Microsoft 365 |

| CRM | HubSpot, Salesforce, Pipedrive |

| Datenbanken | PostgreSQL, MySQL, Supabase, MongoDB |

| Cloud | AWS, Google Cloud, Azure, Vercel |

Roadmap 2025:

- ✅ Q1 2025: MCP 1.0 Release (Anthropic)

- ✅ Q2 2025: Erste Enterprise-Adopters (inkl. Anewera)

- 🚧 Q3 2025: MCP SDKs für alle Major Languages

- 🔜 Q4 2025: 500+ Tools mit Native MCP-Support

Warum MCP zum Standard werden wird

1. Anthropic's Backing

Anthropic ist nicht irgendein Startup – es ist das führende AI-Unternehmen neben OpenAI. Claude 3.5 Sonnet und Opus sind die leistungsstärksten AI-Modelle 2025.

2. Open-Source & Community

MCP ist Open-Source (Apache 2.0). Die Community wächst exponentiell:

- GitHub Stars: 15.000+ (Stand Nov 2025)

- Contributors: 500+

- Production Deployments: 1.000+

3. Enterprise-Features

MCP bietet, was Enterprises brauchen:

- ✅ SOC2 Type II konform

- ✅ GDPR-compliant

- ✅ Self-hostable

- ✅ Air-gapped deployments möglich

- ✅ Audit-Trails für Compliance

4. Developer Experience

Entwickler lieben MCP, weil es drastisch einfacher ist als REST APIs: 87% weniger Code, 90% weniger Fehler, 93% schnelleres Setup.

Wie Sie MCP in Ihrer Infrastruktur implementieren

Step 1: MCP Server Installation

MCP Server kann als Docker-Container deployed werden. Die Installation dauert unter 5 Minuten.

Step 2: Tools konfigurieren

In einer YAML-Konfigurationsdatei werden alle Tools mit ihren Authentifizierungs-Methoden definiert. Secrets werden über Vault oder ähnliche Services verwaltet, nie im Klartext.

Step 3: Agent implementieren

Der Agent-Code nutzt das MCP SDK (verfügbar für Python, TypeScript, Go, Rust). Die API ist einheitlich über alle Tools hinweg.

Step 4: Monitoring & Observability

MCP Server bietet Out-of-the-box Metriken:

- Request Count & Duration

- Error Rates

- Token Usage

- Rate-Limit Hits

Alerts können für verschiedene Bedingungen konfiguriert werden (z.B. hohe Error-Rate, Rate-Limit erreicht).

Anewera's MCP-Infrastruktur

Bei Anewera nutzen wir MCP produktiv für:

- ✅ 100+ Tool-Integrationen (Google, HubSpot, Slack, Notion, ...)

- ✅ 50+ AI Agents im Einsatz bei Schweizer KMUs

- ✅ 1 Mio+ MCP Requests pro Monat

- ✅ 99.9% Uptime dank Built-in Retry-Logic

Performance-Daten (Oktober 2025):

| Metrik | Wert |

|---|---|

| Durchschnittliche Response-Zeit | 120ms |

| Fehlerrate | 0.3% |

| Token-Refresh-Failures | 0 (automatisch) |

| Security-Incidents | 0 |

| Developer-Zufriedenheit | 9.5/10 |

Fazit: MCP ist die Zukunft

Das Model Context Protocol löst die fundamentalen Probleme traditioneller API-Integrationen:

✅ Stateful statt Stateless – Agents behalten Kontext

✅ Unified Auth – Ein Layer für alle Tools

✅ Built-in Resilience – Automatisches Error-Handling

✅ Enterprise-Ready – Security, Compliance, Observability

Bei Anewera setzen wir bereits auf MCP – und die Resultate sprechen für sich:

- -87% weniger Code

- -90% weniger Fehler

- -93% schnelleres Setup

- 10x bessere Developer Experience

Möchten Sie AI Agents mit MCP Server in Ihrem Unternehmen einsetzen? Kontaktieren Sie Anewera für eine kostenlose Beratung.

Verwandte Artikel

- Daytona Sandboxes: Sichere Infrastruktur für KI-Agenten

- Was sind KI-Agenten und wie verändern sie die Arbeit in Schweizer KMU?

- A New Era: Ein Agent, der Agenten erstellt

Häufig gestellte Fragen (FAQ)

Ist MCP Open-Source?

Ja, MCP ist Open-Source unter Apache 2.0 Lizenz und kann selbst gehostet werden.

Welche Programmiersprachen werden unterstützt?

Aktuell gibt es offizielle SDKs für Python, TypeScript, Go und Rust. Community-SDKs für weitere Sprachen sind in Entwicklung.

Ist MCP GDPR-konform?

Ja, MCP ist GDPR-konform. Sie können den Server in der Schweiz/EU hosten und haben volle Kontrolle über alle Daten.

Wie hoch sind die Kosten?

MCP Server selbst ist kostenlos (Open-Source). Sie zahlen nur für die Infrastruktur (Server, Storage) und die genutzten APIs.

Kann ich MCP mit bestehenden REST APIs nutzen?

Ja, Sie können REST APIs über MCP-Adapter integrieren und von den MCP-Features (Auth, Retry, Rate-Limiting) profitieren.